- Что такое robots.txt?

- Использование robots.txt для целей SEO-продвижения

- Управление краулинговым бюджетом

- Оптимизация индексации

- Предотвращение попадания нежелательного контента в выдачу

- Обработка robots.txt поисковыми системами

- Обработка robots.txt в Google

- Обработка robots.txt в Яндексе

- Правила настройки robots.txt

- Основные директивы

- Использование специальных символов

- Дополнительные директивы

- Частые ошибки и способы их выявления

- Типичные ошибки в robots.txt

- Методы выявления ошибок

- Примеры правильной настройки

- Примеры неправильной настройки

- Специальные случаи и продвинутые техники

- Настройка для разных поисковых систем

- Работа с поддоменами

- Обработка параметров URL

- Инструменты для работы с robots.txt

- Официальные инструменты поисковых систем

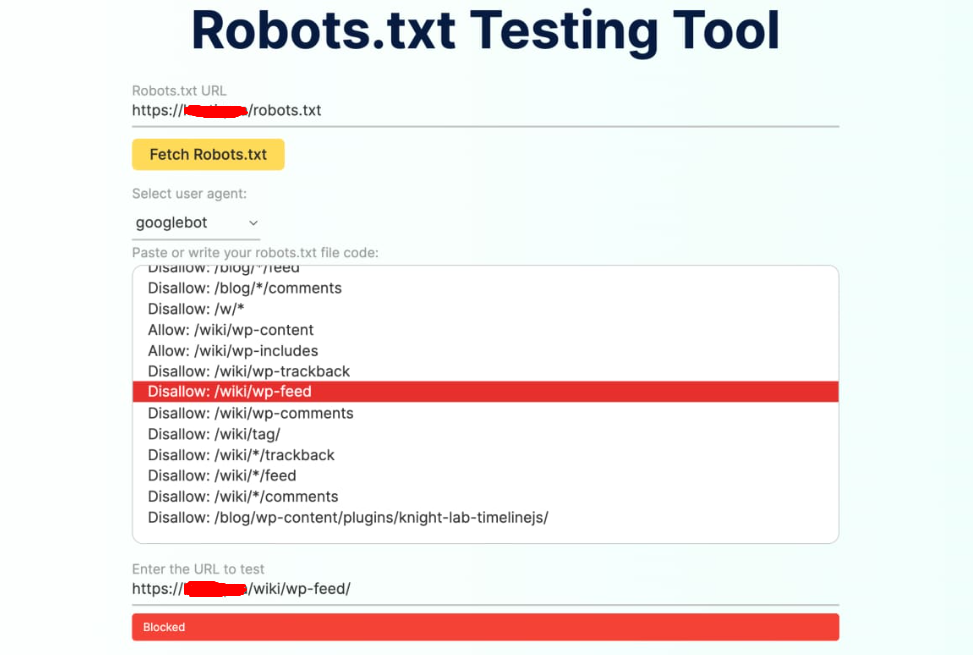

- Сторонние инструменты

- Заключение

Файл robots.txt является одним из важнейших инструментов в арсенале любого веб-мастера и SEO-специалиста. Этот простой текстовый файл играет ключевую роль в управлении поисковыми роботами и влияет на то, как поисковые системы индексируют ваш сайт. В данном материале мы подробно рассмотрим все аспекты работы с robots.txt, от базовых понятий до продвинутых техник настройки.

Что такое robots.txt?

Robots.txt — это стандартный текстовый файл в кодировке UTF-8, который содержит инструкции для поисковых роботов всех типов относительно индексирования вашего сайта. Файл определяет, какие страницы и разделы сайта должны сканироваться поисковыми системами, а какие следует пропустить.

Данный файл является первым документом, который проверяют поисковые роботы при посещении любого веб-ресурса. Он должен располагаться в корневом каталоге сайта и быть доступен по адресу https://yoursite.com/robots.txt. Размер файла не должен превышать 500 КБ согласно рекомендациям Google.

Для лучшего понимания принципа работы robots.txt можно провести аналогию с привратником или администратором гостиницы. Представьте, что ваш сайт — это большое здание, а поисковые роботы — посетители, которые хотят осмотреть все помещения.

Файл robots.txt выполняет роль администратора на ресепшене, который встречает каждого посетителя и объясняет правила:

- «Добро пожаловать! Вы можете свободно посещать холл, конференц-залы и выставочные помещения»

- «Однако служебные помещения, архив документов и личные кабинеты сотрудников закрыты для посещения»

- «Карта здания находится вон там, на стойке информации»

Точно так же robots.txt «встречает» поисковых роботов и направляет их по сайту, указывая доступные для сканирования разделы и предупреждая о закрытых зонах.

Использование robots.txt для целей SEO-продвижения

Правильно настроенный файл robots.txt оказывает значительное влияние на SEO-оптимизацию сайта и его позиции в поисковой выдаче. Рассмотрим основные стороны.

Управление краулинговым бюджетом

Краулинговый бюджет — это ограниченное количество страниц, которое поисковые роботы могут просканировать за один визит на сайт. Google и другие поисковые системы выделяют определенное количество ресурсов для каждого сайта, и важно использовать их эффективно.

С помощью robots.txt можно:

- Закрыть от индексации технические страницы и дубли контента

- Направить роботов к наиболее важным разделам сайта

- Предотвратить сканирование неинформативных страниц

- Снизить нагрузку на сервер за счет уменьшения количества запросов

Оптимизация индексации

Файл robots.txt помогает поисковым системам правильно понимать структуру сайта и индексировать только релевантный контент. Это особенно важно для:

- Интернет-магазинов с большим количеством товарных позиций

- Сайтов с динамическими URL и параметрами

- Ресурсов с большим объемом пользовательского контента

Предотвращение попадания нежелательного контента в выдачу

Robots.txt позволяет исключить из индексации:

- Страницы личных кабинетов пользователей

- Служебные разделы и административные панели

- Результаты внутреннего поиска

- Страницы с конфиденциальной информацией

Обработка robots.txt поисковыми системами

Различные поисковые системы по-разному интерпретируют и обрабатывают файл robots.txt. Рассмотрим особенности работы с этим файлом для двух основных поисковиков российского сегмента интернета.

Обработка robots.txt в Google

Google рассматривает содержимое robots.txt как рекомендации, а не строгие правила. Основные особенности обработки:

Технические требования:

- Размер файла не должен превышать 500 КБ

- Кодировка UTF-8 (включая символы ASCII)

- Файл должен быть доступен по протоколу HTTP/HTTPS

Поведение при различных ответах сервера:

- 2xx — файл успешно загружен и обработан

- 3xx — Google следует по редиректам (максимум 5 переходов)

- 4xx — отсутствие файла интерпретируется как разрешение сканировать весь сайт

- 5xx — временные ошибки сервера, сканирование блокируется

Специальные роботы Google:

- Googlebot — основной робот для индексации

- Googlebot-Image — для сканирования изображений

- Googlebot-Video — для видеоконтента

- Googlebot-News — для новостных сайтов

- AdsBot-Google — для проверки рекламных объявлений

Обработка robots.txt в Яндексе

Яндекс более строго следует директивам robots.txt по сравнению с Google. Особенности обработки:

Поддерживаемые директивы:

- User-agent — указание робота

- Disallow — запрет сканирования

- Allow — разрешение сканирования

- Sitemap — указание местоположения карты сайта

- Clean-param — обработка параметров URL

- Crawl-delay — задержка между запросами

Специальные возможности:

- Яндекс поддерживает кириллические URL в robots.txt

- Возможность указания времени задержки между запросами

- Обработка специальных параметров через Clean-param

Правила настройки robots.txt

Для создания работающего на SEO файла robots.txt необходимо следовать определенным правилам и рекомендациям. Рассмотрим основные настройки.

Основные директивы

User-agent — обязательная директива, указывающая, для какого робота предназначены следующие правила:

User-agent: * # Для всех роботов User-agent: Googlebot # Только для Google User-agent: Yandex # Только для Яндекса

Disallow — запрещает сканирование указанных разделов:

Disallow: /admin/ # Запрет папки admin Disallow: /private.html # Запрет конкретного файла Disallow: / # Запрет всего сайта

Allow — разрешает сканирование (используется для исключений):

Allow: /public/ # Разрешение для папки public Allow: / # Разрешение для всего сайта

Использование специальных символов

Robots.txt поддерживает использование специальных символов для более гибкой настройки:

Звездочка (*) — обозначает любую последовательность символов:

Disallow: *.pdf$ # Запрет всех PDF файлов Disallow: /*?* # Запрет URL с параметрами

Доллар ($) — обозначает конец URL:

Disallow: /temp$ # Запрет только /temp, но не /temp/

Решетка (#) — для комментариев:

# Это комментарий User-agent: * Disallow: /admin/ # Закрываем админку

Дополнительные директивы

Sitemap — указание местоположения карты сайта:

Sitemap: https://example.com/sitemap.xml

Crawl-delay — задержка между запросами (в секундах):

Crawl-delay: 2 # Задержка 2 секунды

Clean-param — для Яндекса, убирает параметры из URL:

Clean-param: utm_source&utm_medium&utm_campaign

Частые ошибки и способы их выявления

При создании и настройке robots.txt веб-мастера часто допускают ошибки, которые могут негативно повлиять на индексацию сайта. Рассмотрим распространенные проблемы и способы их решения.

Типичные ошибки в robots.txt

1. Перепутанные директивы

# Неправильно: User-agent: * Disallow: Googlebot # Правильно: User-agent: Googlebot Disallow: /

2. Несколько URL в одной директиве Disallow

# Неправильно: Disallow: /admin/ /tmp/ /private/ # Правильно: Disallow: /admin/ Disallow: /tmp/ Disallow: /private/

3. Неправильное название файла

Файл должен называться именно robots.txt (строчными буквами), а не Robots.txt или ROBOTS.TXT.

4. Пустое поле User-agent

# Неправильно: User-agent: Disallow: /admin/ # Правильно: User-agent: * Disallow: /admin/

5. Неправильное использование символов подстановки

# Неправильно: Disallow: /example* # Правильно: Disallow: /*example*

Методы выявления ошибок

1. Проверка синтаксиса

Используйте онлайн-валидаторы для проверки корректности синтаксиса файла. Основные инструменты:

2. Тестирование URL

Регулярно проверяйте, правильно ли robots.txt блокирует или разрешает доступ к конкретным URL:

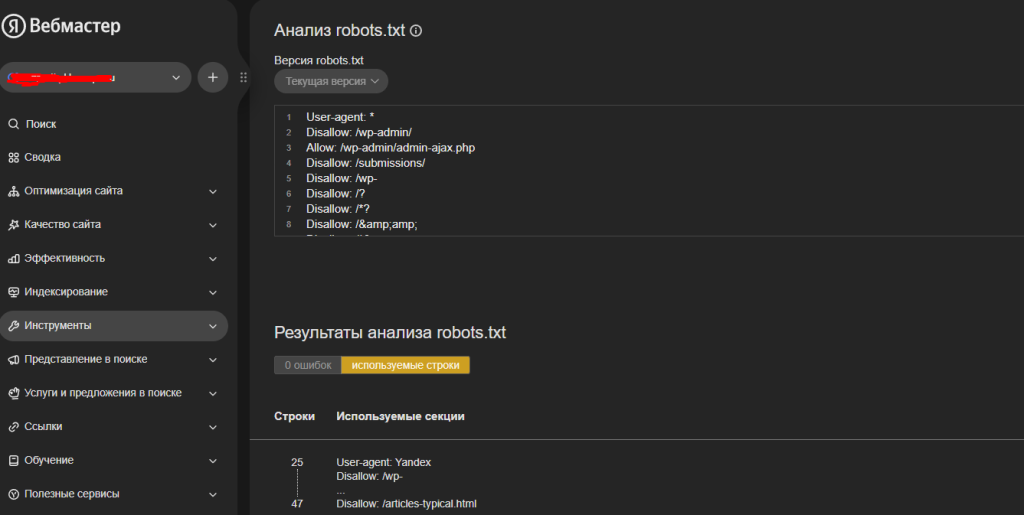

Яндекс.Вебмастер: «Инструменты» — «Анализ robots.txt»

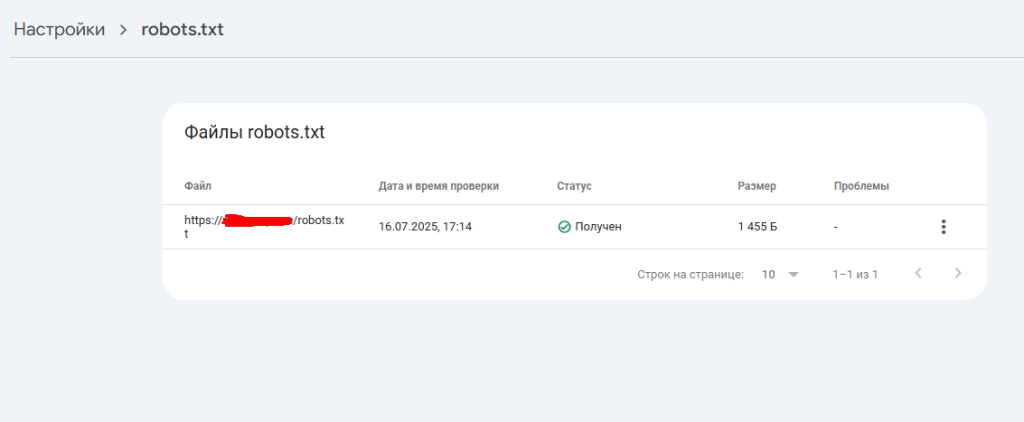

Google Search Console: «Настройки» — «robots.txt»

3. Мониторинг логов сервера

Анализируйте логи веб-сервера для выявления попыток доступа роботов к заблокированным ресурсам.

4. Регулярный аудит

Проводите регулярные проверки robots.txt, особенно после:

- Изменения структуры сайта

- Добавления новых разделов

- Обновления CMS или движка сайта

Примеры правильной настройки

Базовый корректный robots.txt для CMS WordPress:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /wp-content/plugins/ Disallow: /cgi-bin/ Allow: /wp-content/uploads/ Sitemap: https://example.com/sitemap.xml

Для интернет-магазина на WooCommerce:

User-agent: * Disallow: /cart/ Disallow: /checkout/ Disallow: /account/ Disallow: /search?* Disallow: /*?sort=* Disallow: /*?filter=* Allow: /wp-content/uploads/ Allow: /images/ Sitemap: https://shop.com/sitemap.xml

Для новостного сайта:

User-agent: * Disallow: /admin/ Disallow: /private/ Disallow: /draft/ Allow: /news/ Allow: /articles/ User-agent: Googlebot-News Disallow: /archive/ Allow: /news/ Sitemap: https://news.com/sitemap.xml

Примеры неправильной настройки

Критическая ошибка — блокировка всего сайта:

# НЕПРАВИЛЬНО! Закрывает весь сайт User-agent: * Disallow: /

Противоречащие друг другу директивы:

# НЕПРАВИЛЬНО! Противоречивые команды User-agent: * Disallow: /catalog/ Allow: /catalog/

Ошибки синтаксиса:

# НЕПРАВИЛЬНО! Отсутствует двоеточие User-agent * Disallow /admin/

Блокировка важных ресурсов помогающих правильно отображать контент:

# НЕПРАВИЛЬНО! Блокирует CSS и JS User-agent: * Disallow: /css/ Disallow: /js/ Disallow: /images/

Специальные случаи и продвинутые техники

Настройка для разных поисковых систем

Иногда требуется настроить разные правила для различных поисковых роботов:

# Для Google User-agent: Googlebot Disallow: /private/ Allow: /public/ # Для Яндекса User-agent: Yandex Disallow: /private/ Disallow: /temp/ Crawl-delay: 2 # Для всех остальных User-agent: * Disallow: /

Работа с поддоменами

Каждый поддомен должен иметь свой собственный файл robots.txt:

https://www.example.com/robots.txthttps://blog.example.com/robots.txthttps://shop.example.com/robots.txt

Обработка параметров URL

Для Яндекса можно использовать директиву Clean-param:

User-agent: Yandex Clean-param: utm_source&utm_medium&utm_campaign Clean-param: ref&sid

Инструменты для работы с robots.txt

Официальные инструменты поисковых систем

Google Search Console:

- Тестирование robots.txt

- Просмотр заблокированных URL

- История изменений файла

Яндекс.Вебмастер:

- Анализ robots.txt

- Проверка доступности URL

- Рекомендации по улучшению

Сторонние инструменты

- Robots.txt Checker — онлайн-валидаторы

- Screaming Frog — анализ сайта и robots.txt

- Netpeak Spider — проверка соответствия robots.txt и sitemap

Заключение

Файл robots.txt является мощным инструментом для управления поисковыми роботами и оптимизации индексации сайта. Правильная настройка этого файла может значительно улучшить SEO-показатели вашего ресурса, обеспечить более эффективное использование краулингового бюджета и предотвратить попадание нежелательного контента в поисковую выдачу.

Ключевые принципы работы с robots.txt:

- Простота и ясность — избегайте сложных конструкций

- Регулярное тестирование — проверяйте работоспособность после каждого изменения

- Мониторинг результатов — отслеживайте влияние изменений на индексацию

- Соответствие целям — настройки должны поддерживать бизнес-задачи сайта

Помните, что robots.txt — это инструмент рекомендаций, а не строгих правил. Для критически важных ограничений используйте дополнительные методы защиты и управления доступом.